KI-Toolbox für Versorgungsunternehmen: Modul Rechtliches und Regularien

Dieses Modul befasst sich mit den rechtlichen Aspekten eines KI-Betriebs. Es werden wichtige Fragen aufgeworfen, mit denen man sich in diesem Kontext bereits in der Planung, aber auch im laufenden Betrieb befassen muss, und erste Antworten mit zahlreichen Ressourcen zur tieferen Auseinandersetzung geliefert. Anschließend präsentieren wir ein Konzept zur Bewältigung dieser Fragen in vier kompakten Schritten.

Sollen in einem (Versorgungs-)Unternehmen Anwendungen und Methoden der Künstlichen Intelligenz eingeführt werden, stellen sich unweigerlich zahlreiche rechtliche Fragen. Welche Daten dürfen für die Anwendung genutzt werden, welche nicht oder nur unter bestimmten Voraussetzungen? Sind diese erfüllt? Wer lernt die KI auf welche Weise an und wer überprüft die Ergebnisse, die sie hervorbringt? Sind die Entscheidungen, die ein Algorithmus trifft, wirklich objektiv? Oder laufen wir Gefahr, gesellschaftliche Verzerrungen zu verstärken und bestimmte Gruppen – unbewusst – zu diskriminieren? Wer haftet, wenn ein Algorithmus falsche Entscheidungen trifft? Stellt eine kommerzielle Cloud-Lösung ein Sicherheitsrisiko für das Unternehmen dar? Muss der Betriebsrat eingebunden werden, wenn eine KI-Anwendung interne Leistungsprozesse automatisiert? Und wem gehören eigentlich die KI und die Ergebnisse, die sie produziert? Die juristischen Fragen rund um Anwendungen der Künstlichen Intelligenz sind vielfältig, und es gibt nicht auf alle Fragen und für jeden Anwendungsfall eindeutige Antworten. Dies macht die rechtliche Auseinandersetzung mit KI zu einer kniffligen, aber überaus wichtigen Angelegenheit. Damit Ihnen der Einstieg gelingt, geben wir Ihnen nachstehend einen Überblick über wichtige juristische Bereiche, mit denen Sie sich in Bezug auf die KI-Anwendung frühzeitig auseinandersetzen sollten, zeigen ein grobes Vorgehen zur Erörterung der genannten Fragen auf und stellen Ihnen Praxishilfen, Literaturtipps und gelungene Fallbeispiele zur Verfügung.

Überblick: Welche Gesetze sind bei KI-Anwendungen besonders berührt?

Grundgesetz

Die im Grundgesetz formulierten Grundrechte aller Menschen bilden den verbindlichen Rahmen allen gesellschaftlichen Handelns in Deutschland. In Bezug auf KI-Anwendungen sind die Unantastbarkeit der Würde des Menschen, das Recht auf persönliche Freiheit (freie Entfaltung der Persönlichkeit, Recht auf Leben und körperliche Unversehrtheit), die Gleichheit vor dem Gesetz sowie die Meinungs- und Informationsfreiheit besonders hervorzuheben. Aus den Grundrechten lassen sich konkrete Standards ableiten, die eine KI erfüllen muss, um grundrechtskonform und „gut“ im ethischen Sinne zu sein.

Datenschutz-Grundverordnung

Im Grundgesetz wird das Recht auf informationelle Selbstbestimmung nicht explizit genannt, jedoch leitet das Bundesverfassungsgericht ein solches Grundrecht aus dem Grundgesetz ab. Die Datenschutz-Grundverordnung (DS-GVO) der EU sowie Artikel 8 der EU-Grundrechtecharta schützen überdies personenbezogene Daten explizit.

Die Datenschutz-Grundverordnung regelt die Erhebung, Speicherung und Verarbeitung personenbezogener Daten in der EU und gewährt diese nur aufgrund einer Zweckbindung und bei Vorliegen eines sogenannten Erlaubnistatbestands, d. h. nur unter bestimmten Voraussetzungen (z. B. Einwilligung der betroffenen Person, Unabdingbarkeit zur Vertragserfüllung oder aus rechtlicher Verpflichtung, Schutz lebenswichtiger Interessen, Wahrnehmung einer Aufgabe im öffentlichen Interesse, Wahrung berechtigter Interessen Dritter). Ob die Voraussetzungen erfüllt sind, ist jedoch nicht immer ganz eindeutig und stellt oftmals eine Interessenabwägung dar. Um aufwendige juristische Debatten zu vermeiden, lohnt es sich daher zu fragen, ob das Ziel der KI-Anwendung auch ohne personenbezogene Daten erreicht werden kann, indem beispielsweise ausschließlich Daten ohne Personenbezug genutzt werden oder personenbezogene Daten bereits bei der Erhebung und vor der Speicherung mit Methoden der Mathematik (Stichwort: differential privacy) oder mit Hilfe von technischen Verfahren (siehe u. a. datenschutzkonforme Überwachungssysteme) vollständig anonymisiert werden. Weitere Beispiele zum konstruktiven Umgang mit dem Datenschutz in der Praxis finden Sie in der Publikation von BMVi.

Soll bzw. muss dennoch mit personenbezogenen Daten gearbeitet werden, empfiehlt sich die Erstellung eines Datenschutzkonzepts. Dabei kann man sich an dieser Beispiel-Struktur orientieren und auch die Aufsichtsbehörde (z. B. Landesdatenschutzbeauftragte*r) einbeziehen.

Patentrecht

Hierbei stellt sich die Frage, ob ein Unternehmen eine KI-Anwendung patentieren, also ihre wirtschaftliche Verwertung schützen kann. Software als solche ist nicht patentierbar, da sie für sich genommen als nicht-technisch anzusehen ist. Kann man jedoch die Technizität einer Software begründen, da die Software ein technisches Problem durch technische Mittel löst, ist es möglich, diese zu patentieren. Die Technizität kann dann gegeben sein, wenn die Software einen Computer benötigt, um die Verfahrensschritte auszuführen und ein technisches Problem zu lösen, oder wenn mit Hilfe der Software technische Einrichtungen gesteuert, geregelt oder überwacht werden sollen. Die Herausforderung liegt also darin, den Patentanspruch so zu formulieren, dass die Technizität bejaht wird.

Urheberrecht

Beim Urheberrecht stellt sich die Frage, wer der/die Schöpfer*in der KI und der von ihr erzeugten Ergebnisse ist. In Bezug auf schwache KI ist die Rechtslage heute klar: Da das Ergebnis der KI vorhersehbar ist, dient die KI lediglich als Werkzeug und der/die Entwickler*in besitzt das Urheberrecht an den Erzeugnissen. Dazu muss der/die Entwickler*in nicht jedes mögliche Ergebnis der KI im Vorfeld absehen können, allerdings muss klar sein, welche Art von Ergebnissen durch die KI möglich ist. Wenn also eine schwache KI die Bilder von Kleidungsstücken analysiert, um zukünftig selbstständig Teile zu kategorisieren, hat der/die Entwickler*in die Urheberrechte an der Kategorisierung. Entwickelt hingegen eine starke KI, basierend auf den Bildern, autonom eigene Designs von Kleidungsstücken, so ist zum jetzigen Zeitpunkt nicht klar, wer das Urheberrecht an diesen Designs besitzt. (Für derartig autonom agierende KI-Anwendungen werden derzeit Gesetzesvorschläge, nicht nur zum Urheberrecht, sowie Ethikrichtlinien diskutiert. Einblick in den aktuellen Stand der Debatte liefert der Legislative Train.)

Arbeitsrecht

Soll eine KI im Unternehmen eingesetzt werden, um Leistungsprozesse zu unterstützen oder diese vollständig zu automatisieren, müssen auch bestimmte arbeitsrechtliche Aspekte beachtet werden. Beispielsweise darf eine KI nicht dazu eingesetzt werden können (unabhängig vom intendierten Zweck), Mitarbeitende und ihre individuellen Leistungen zu überwachen. Soll eine KI eingesetzt werden, um Personalentscheidungen zu unterstützen, so muss sichergestellt sein, dass die KI transparent, nachvollziehbar und fair handelt und die Grundsätze der Menschenwürde, der Persönlichkeitsrechte, der Nichtdiskriminierung und der Mitbestimmung respektiert – ein hoher und wichtiger Maßstab. Eine detaillierte Auseinandersetzung mit arbeitsrechtlichen Fragen findet sich in "Industrie 4.0 - wie das Recht Schritt hält" des BMWI.

Haftungsrecht

Auch beim Einsatz von KI-Anwendungen können Fehler passieren. Wer haftet dann für einen angerichteten Schaden? Um diese Frage zu klären, muss die Ursache für den Schaden genau untersucht werden. Gab es einen Fehler in der Programmierung? Hat der/die Anwender*in die KI falsch bedient? War die IT-Infrastruktur fehlerhaft oder hatte ein anknüpfendes System (z. B. ein Roboterarm) ein technisches Problem? Je nachdem, was den Schaden verursacht hat, kann die Haftung bei den Programmierer*innen, den Anwender*innen oder den Hersteller*innen der IT-Infrastruktur oder der anknüpfenden Systeme liegen. Üblicherweise haftet bei bereits vertriebenen KI-Lösungen zunächst die/der Produzent*in in ihrer Pflicht zur Verkehrssicherung. Diese Pflichten umfassen:

- Organisationspflichten (die/der Hersteller*in muss den Betrieb so organisieren, dass Fehler durch Kontrollen entdeckt und frühzeitig beseitigt werden können),

- Instruktionspflichten (die/der Hersteller*in muss die/den Nutzer*in über Bedienung und mögliche Gefahrenquellen des Produkts informieren),

- Produktbeobachtungspflichten (die/der Hersteller*in muss Hinweisen auf Fehler und ein Gefährdungspotenzial der Produkte nachgehen) und

- Gefahrabwendungspflichten (die/der Hersteller*in muss erkannte Gefahren bei Gebrauch der Produkte beseitigen und notfalls das Produkt aus dem Markt zurückrufen).

In einem nächsten Schritt sind Regressansprüche möglich: So kann z. B. bei schadhaftem Programmcode die/der Programmierer*in haftbar gemacht werden. Open Source Software ist jedoch i. d. R. von derartigen Regressansprüchen durch ihre Nutzungsbedingungen befreit. Um unangenehme Überraschungen zu vermeiden, wird empfohlen, sich frühzeitig mit Haftungsfragen auseinanderzusetzen. Einen detaillierteren Überblick gibt die Publikation des BMWI "Künstliche Intelligenz und Recht".

IT-Sicherheitsgesetz

Dieses Gesetz richtet sich insbesondere (aber nicht ausschließlich) an Betreiber kritischer Infrastrukturen (z. B. in den Bereichen Wasser, Energie, Abfall, Gesundheit, Telekommunikation) und regelt die Mindeststandards für Informations- und IT-Sicherheit bei den Betreibern, das Meldewesen bei IT-Sicherheitsvorfällen sowie den Bußgeldkatalog. Muss für die Pilotierung oder den operativen Betrieb einer KI-Anwendung die IT-Infrastruktur angepasst oder ergänzt werden (z. B. durch Einbindung von Cloud-Services), muss sichergestellt werden, dass die Mindeststandards der Informations- und IT-Sicherheit weiterhin eingehalten werden. Das IT-Sicherheitsgesetz wurde im Mai 2021 novelliert.

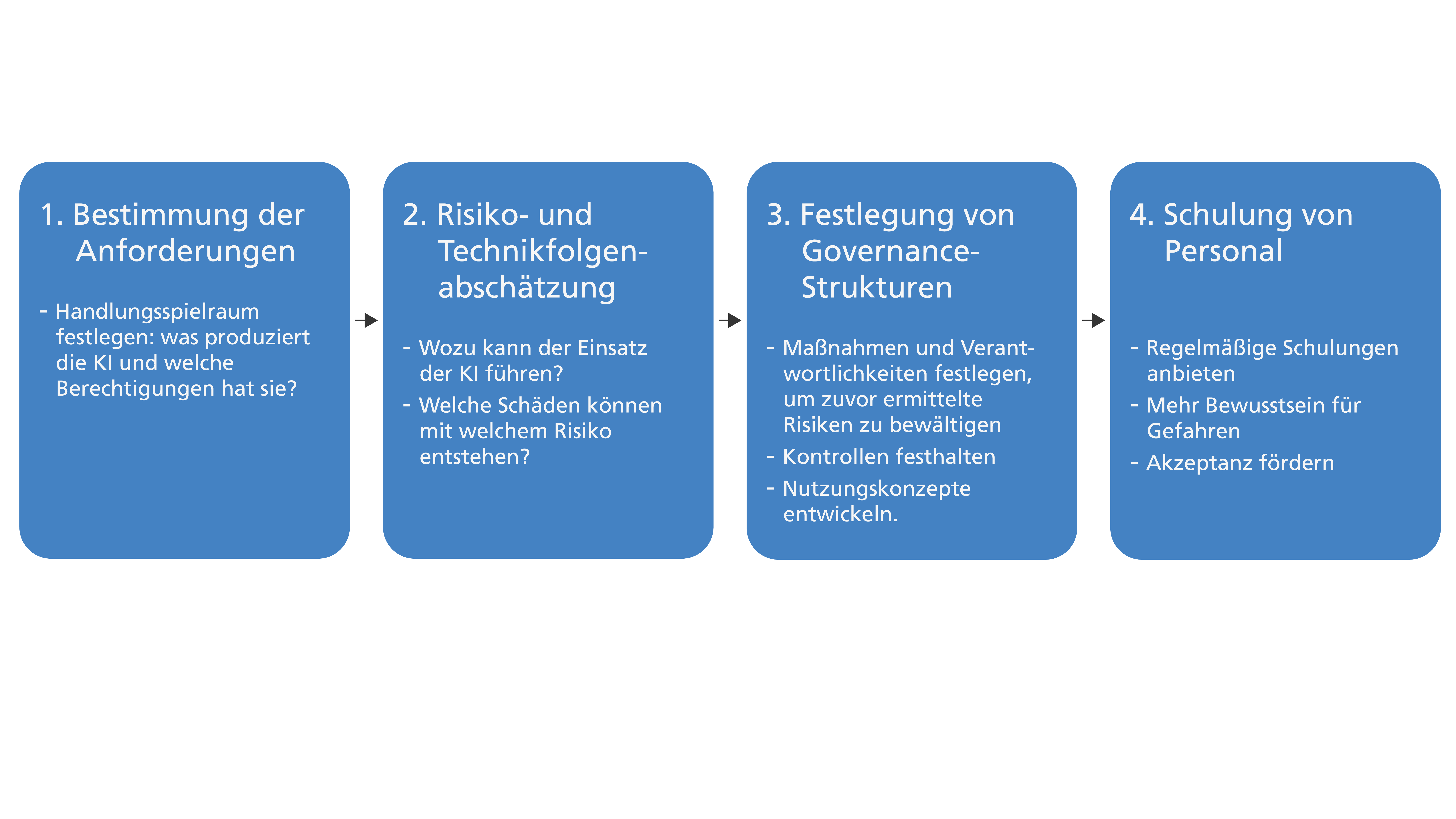

Vorgehensweise zur Entwicklung eines KI-Governance-Konzepts in Ihrem Unternehmen

Um rechtliche Fragen möglichst früh zu erkennen und zu klären, empfiehlt es sich, ein Governance-Konzept für die jeweiligen KI-Anwendungen zu entwickeln. Dazu eignet sich folgende Vorgehensweise:

Schritt 1: Bestimmung der Anforderungen

Im ersten Schritt muss geklärt werden, welche Aufgabe(n) die KI-Anwendung erfüllen soll und welchen Handlungsspielraum sie hat. Zum heutigen Zeitpunkt ist eine KI noch nicht fähig, autonom zu handeln, so dass sich der Handlungsspielraum aus der Programmierung ableitet. Anschließend ist zu klären, welche Datenzugriffe für die Erledigung der Aufgabe erforderlich sind und unter welchen Voraussetzungen die Anwendung verlässlich richtige Ergebnisse erzielt. Grundsätzlich sollten der KI-Anwendung nur die wirklich nötigen Zugriffe gestattet werden, bspw. sollte eine KI zur Aktualisierung einer Kundendatenbank auch nur Zugriff auf die Felder „Adresse“, „Telefonnummer“ usw. haben, nicht aber auf Felder wie „Geburtstag“, „Kundennummer“ oder „Vertragslaufzeit“. Dies stärkt die Transparenz des Systems und damit auch das Vertrauen der Mitarbeitenden und Kunden in die KI.

Schritt 2: Risiko- und Technikfolgenabschätzung

Im zweiten Schritt muss hinterfragt werden, welche Risiken mit der KI-Anwendung verbunden sind bzw. sein können und welche (unerwünschten) Folgen die Einführung der Technologie mit sich bringen kann. Heutige KI-Anwendungen bedienen sich mathematisch-statistischer Verfahren, um Muster in Daten zu erkennen und diese auf neue Daten anzuwenden. Dabei ist es möglich, dass die KI in den Trainingsdaten vorhandene Verzerrungen und Diskriminierungen – von den Entwickler*innen unbeabsichtigt – reproduziert und verstärkt oder dass das entwickelte KI-Verfahren für andere, unethische Zwecke missbraucht werden kann (Stichwort: dual use, Beispiel: deepfakes, staatliche Überwachung). Gerade Unternehmen der öffentlichen Daseinsvorsorge sind gefordert, besonders vorausschauend und verantwortungsvoll zu handeln. Dazu ist es erforderlich, die KI-Anwendung sowie den Kontext, in dem sie eingesetzt wird, genau zu betrachten und das Schadenspotenzial aus unterschiedlichen Blickwinkeln zu bewerten (z. B. technisch, unternehmensbezogen, mitarbeiterbezogen, kundenbezogen, gesellschaftlich). Nicht alle Risiken können gänzlich ausgeschlossen werden, jedoch bedarf es im nächsten Schritt der Entwicklung von Maßnahmen, um die Risiken zu minimieren. So benötigt z. B. eine KI zur intelligenten Türsteuerung Elektromotoren an den Türen, welche bei einem Stromausfall erhöhten Widerstand liefern und schwerer zu öffnen sind. Diese Gefahr bedeutet nicht, dass eine intelligente Türsteuerung nicht zum Einsatz kommen darf, sondern dass eine Lösung erarbeitet werden muss, um in Notfällen, wie z. B. bei einem Gebäudebrand, das einfache Öffnen der Türen zu gewährleisten.

Das Fraunhofer IAIS bietet mit seinem KI-Prüfkatalog einen Leitfaden zur Gestaltung vertrauenswürdiger Künstlicher Intelligenz und gibt Best-Practice-Beispiele für ein gelungenes Risikomanagement an die Hand.

Schritt 3: Festlegung von Governance-Strukturen

Für die zuvor ermittelten Risiken müssen Maßnahmen und Verantwortlichkeiten festgelegt werden, um diesen zu begegnen und das Schadenspotenzial zu mindern. Darüber hinaus müssen Mechanismen entwickelt und implementiert werden, um die kritischen Aspekte regelmäßig zu überwachen und den Betrieb der KI-Anwendung zu kontrollieren. Je nach Anwendungsgebiet der KI können die Regelungen unterschiedlich ausfallen. Die wichtigsten Bereiche werden kurz mit Links zu weiterführenden Informationen aufgeführt:

- Technologisch: Wie werden die KI-Anwendung und die von ihr erzeugten Ergebnisse kontinuierlich überwacht, wie wird sie (weiter-)entwickelt und wie, wann und von wem werden technische Fehler identifiziert und behoben?

- IT-Sicherheit: Welche Infrastruktur ist für den sicheren KI-Betrieb erforderlich? Wie, wie oft und von wem wird die Infrastruktur überprüft? Wie, wann und von wem werden (Sicherheits-)Updates durchgeführt? Die KRITIS-Vorgaben für IT-Sicherheit sehen vor, dass u. a. Gebäudeleittechnik, Zutrittsmanagement-, Brandmelde- und Überwachungssysteme, aber auch Firewalls, Load Balancer, Speicher- und Monitoringsysteme besonders zu schützen sind. An derartigen Richtlinien können sich auch Nicht-KRITIS-Unternehmen orientieren.

- Datenschutz: Welche Daten werden erhoben/gespeichert/verarbeitet? Wie werden diese genutzt und geschützt? Inwiefern und von wem wird der effektive Datenschutz regelmäßig überprüft? Wer ist Datenschutzbeauftragte*r im Unternehmen?

- Haftung: Wer trägt die Verantwortung für die KI? Wer haftet im Schadensfall?

- Ethik: Welche Entscheidungen darf die KI treffen? Sind die Folgen des KI-Betriebs mit den Leitlinien für eine rechtmäßige, ethische und robuste KI vereinbar?

- Arbeitsrecht: Inwiefern sind von dem Einsatz von KI die Rechte der Arbeitnehmer*innen betroffen? Ist der Betriebsrat in das KI-Projekt eingebunden? Wie wird sichergestellt, dass die KI-Anwendung nicht zur Überwachung der Mitarbeitenden oder für andere, unethische Zwecke missbraucht werden kann?

Die Maßnahmen, Verantwortlichkeiten, Strukturen und Prozesse in den genannten Bereichen sollten jeweils in einem Konzept festgehalten werden. Kontrollen können intern oder durch eine externe, unabhängige Institution (z. B. in Form eines Audits oder einer Zertifizierung) durchgeführt werden. Externe Kontrollen können zwar mit einem großen bürokratischen Aufwand verbunden sein, sind jedoch objektiver und stärken damit die Vertrauenswürdigkeit der KI-Anwendung und Ihres Unternehmens. In diesem Sinne sind sie auch eine Investition in das Image Ihrer KI-Anwendung und Ihres Betriebs.

Schritt 4: Schulung von Personal

Der letzte Schritt sieht vor, die Kompetenzen der Mitarbeiter*innen im eigenen Unternehmen zu stärken. Durch regelmäßige Schulungen lernen die Mitarbeiter*innen, besser mit der KI umzugehen, was die Effizienz steigert. Gleichzeitig wird das Bewusstsein für Risiken und mögliche Gefahren im Umgang mit der KI geschärft und so für eine höhere Sicherheit gesorgt. Wichtig ist dabei, dass die Schulungen im Rahmen der regulären Arbeitszeit stattfinden und nicht als Extraaufgabe in der Freizeit angesetzt werden. Das ist nicht nur aus arbeitsrechtlicher Sicht notwendig, sondern verringert auch die Frustration gegenüber KI. Durch alle diese Schritte wird so ein positives Bild der KI gestärkt und ihre Akzeptanz gefördert.

Best-Practice-Beispiele

- Eine transparente Datenschutzerklärung mit offengelegtem Datennutzungskonzept zeigt Planet AI, ein Entwickler von Bild-, Sprach- und Schrifterkennung für die Verkehrsüberwachung.

- Die Lufthansa liefert eine Aufklärung und ihre Guidelines zu einem ethisch verantwortlichen Umgang mit KI.

- Um Bürger*innen in Deutschland während der Pandemie zu schützen und Infektionsketten zu unterbinden, beauftragte die Bundesregierung die Deutsche Telekom und SAP mit der Entwicklung der Corona Warn App. Innerhalb kürzester Zeit wurde dank umfassender Risikoabschätzung eine besonders sichere Tracking-Technik entwickelt. Die Herangehensweise und die Dokumentation setzen Maßstäbe für einen konstruktiven und effizienten Umgang mit KI, gerade bei kritischen Themen wie Smartphone-Tracking.